Метод наименьших квадратов

Метод наименьших квадратов является мощным инструментом для аппроксимации данных и нахождения зависимостей между переменными. Он минимизирует сумму квадратов отклонений между наблюдаемыми значениями и значениями, предсказанными моделью. В линейных моделях существуют аналитические решения, но для нелинейных моделей часто применяются численные методы оптимизации.

Метод наименьших квадратов (МНК) — это статистический метод, используемый для нахождения наилучшей аппроксимации зависимости между переменными. Он минимизирует сумму квадратов отклонений между наблюдаемыми значениями и значениями, предсказанными моделью. Этот метод широко используется в регрессионном анализе, аппроксимации функций и других областях, где требуется найти зависимость между переменными.

Основные концепции метода наименьших квадратов

1. Модель:

- Пусть у нас есть набор данных \((x_i, y_i)\), где \(i = 1, 2, \ldots, n\).

- Мы предполагаем, что данные можно описать некоторой моделью \(y = f(x, \theta)\), где \(\theta\) — это вектор параметров модели.

2. Цель:

- Найти такие параметры \(\theta\), которые минимизируют сумму квадратов отклонений между наблюдаемыми значениями \(y_i\) и значениями, предсказанными моделью \(f(x_i, \theta)\).

3. Функция потерь:

- Функция потерь (или сумма квадратов отклонений) определяется как:

\[

S(\theta) = \sum_{i=1}^{n} (y_i - f(x_i, \theta))^2

\]

- Цель метода наименьших квадратов — найти такие параметры \(\theta\), которые минимизируют \(S(\theta)\).

Пример линейной регрессии

Рассмотрим простой пример линейной регрессии, где модель имеет вид:

\[ y = \beta_0 + \beta_1 x \]

1. Модель:

- Здесь \(\theta = (\beta_0, \beta_1)\) — вектор параметров.

2. Функция потерь:

\[

S(\beta_0, \beta_1) = \sum_{i=1}^{n} (y_i - (\beta_0 + \beta_1 x_i))^2

\]

3. Минимизация функции потерь:

- Для минимизации \(S(\beta_0, \beta_1)\) можно использовать аналитические методы или численные методы оптимизации.

- Аналитическое решение для линейной регрессии дается формулами:

\[

\beta_1 = \frac{\sum_{i=1}^{n} (x_i - \bar{x})(y_i - \bar{y})}{\sum_{i=1}^{n} (x_i - \bar{x})^2}

\]

\[

\beta_0 = \bar{y} - \beta_1 \bar{x}

\]

где \(\bar{x}\) и \(\bar{y}\) — средние значения \(x\) и \(y\) соответственно.

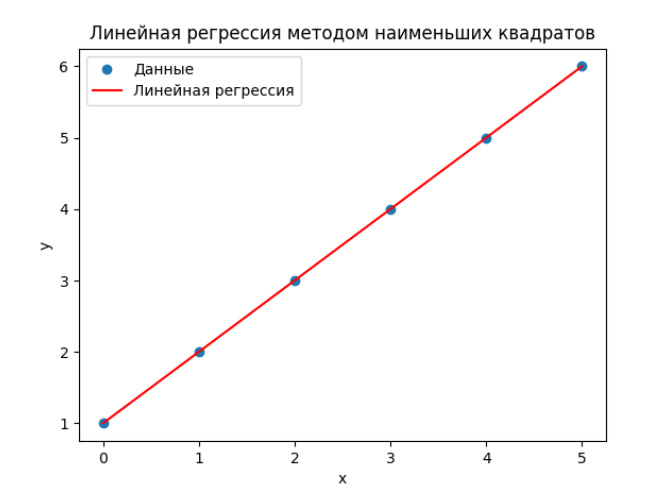

Пример на Python

import numpy as np

import matplotlib.pyplot as plt

from scipy.optimize import curve_fit

# Данные точки

x_data = np.array([0, 1, 2, 3, 4, 5])

y_data = np.array([1, 2, 3, 4, 5, 6])

# Определим функцию линейной регрессии

def linear_model(x, beta0, beta1):

return beta0 + beta1 * x

# Начальные приближения для параметров beta0 и beta1

initial_guess = [0, 1]

# Применение метода наименьших квадратов

params, covariance = curve_fit(linear_model, x_data, y_data, p0=initial_guess)

beta0, beta1 = params

print(f"Параметры линейной регрессии: beta0 = {beta0}, beta1 = {beta1}")

# Построение графика

plt.scatter(x_data, y_data, label='Данные')

plt.plot(x_data, linear_model(x_data, beta0, beta1), color='red', label='Линейная регрессия')

plt.xlabel('x')

plt.ylabel('y')

plt.legend()

plt.title('Линейная регрессия методом наименьших квадратов')

plt.show()

Преимущества и ограничения метода наименьших квадратов

Преимущества:

Простота реализации и интерпретации.

Аналитические решения для линейных моделей.

Широкое применение в различных областях науки и техники.

Ограничения:

Чувствительность к выбросам (outliers).

Предположение о нормальном распределении ошибок.

Не всегда подходит для нелинейных моделей, где требуются численные методы оптимизации.

Дополнительная информация

Вектор параметров модели — это набор переменных, которые определяют форму и поведение модели в математическом или статистическом контексте. Эти параметры описывают, как входные данные преобразуются в выходные значения, и их значения определяются на основе данных или предположений.

Вектор параметров модели играет ключевую роль в различных областях, таких как машинное обучение, статистика, оптимизация и анализ данных. Он позволяет адаптировать модель к конкретным данным, чтобы она могла точно предсказывать или описывать зависимости между переменными.

Примеры векторов параметров модели

1. Линейная регрессия

- Модель: \( y = \beta_0 + \beta_1 x \)

- Вектор параметров: \(\theta = (\beta_0, \beta_1)\)

- \(\beta_0\) — свободный член (интерсепт).

- \(\beta_1\) — коэффициент наклона.

2. Многомерная линейная регрессия

- Модель: \( y = \beta_0 + \beta_1 x_1 + \beta_2 x_2 + \ldots + \beta_n x_n \)

- Вектор параметров: \(\theta = (\beta_0, \beta_1, \beta_2, \ldots, \beta_n)\)

3. Логистическая регрессия

- Модель: \( P(y=1|x) = \frac{1}{1 + e^{-(\beta_0 + \beta_1 x)}} \)

- Вектор параметров: \(\theta = (\beta_0, \beta_1)\)

4. Нейронные сети

- Модель: \( y = f(x; \theta) \), где \(f\) — сложная функция, определяемая архитектурой нейронной сети.

- Вектор параметров: \(\theta = (w_1, w_2, \ldots, w_n, b_1, b_2, \ldots, b_m)\)

- \(w_i\) — веса нейронной сети.

- \(b_i\) — смещения (biases).

Оптимизация вектора параметров

Для того чтобы модель хорошо описывала данные, необходимо найти оптимальные значения параметров. Это обычно достигается с помощью методов оптимизации, таких как:

- Метод наименьших квадратов (МНК): Минимизирует сумму квадратов отклонений между наблюдаемыми значениями и значениями, предсказанными моделью.

- Градиентный спуск: Итеративный метод, который обновляет параметры модели в направлении антиградиента функции потерь.

- Методы второго порядка (например, метод Ньютона): Используют вторые производные для более точного нахождения оптимальных параметров.

Пример на Python

Рассмотрим пример линейной регрессии с использованием библиотеки scikit-learn.

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import LinearRegression

# Данные

x_data = np.array([0, 1, 2, 3, 4, 5]).reshape(-1, 1)

y_data = np.array([1, 2, 3, 4, 5, 6])

# Создание модели линейной регрессии

model = LinearRegression()

# Обучение модели

model.fit(x_data, y_data)

# Вектор параметров модели

beta0 = model.intercept_ # Свободный член

beta1 = model.coef_[0] # Коэффициент наклона

print(f"Параметры модели: beta0 = {beta0}, beta1 = {beta1}")

# Построение графика

plt.scatter(x_data, y_data, label='Данные')

plt.plot(x_data, model.predict(x_data), color='red', label='Линейная регрессия')

plt.xlabel('x')

plt.ylabel('y')

plt.legend()

plt.title('Линейная регрессия')

plt.show()Вектор параметров модели — это ключевой элемент, который определяет, как модель преобразует входные данные в выходные значения. Оптимизация этих параметров позволяет адаптировать модель к конкретным данным, чтобы она могла точно предсказывать или описывать зависимости между переменными. Понимание вектора параметров и методов его оптимизации является основой для успешного применения различных моделей в машинном обучении и статистике.